共计 701 个字符,预计需要花费 2 分钟才能阅读完成。

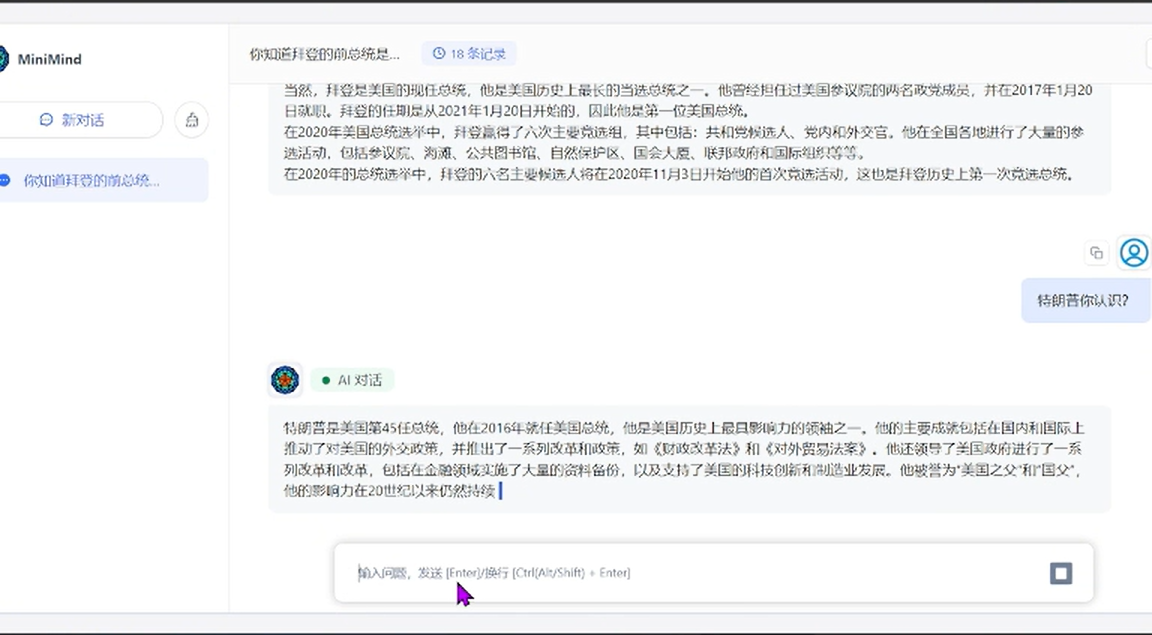

在人工智能领域,大型语言模型(LLMs)因其强大的自然语言处理能力而受到广泛关注。然而,这些模型通常需要大量的计算资源,这限制了它们的普及和应用。作为齐朵网的个人站长,我发现 "MiniMind" 项目为解决这一问题提供了一个创新的解决方案。

主要特点

- 小型参数模型

"MiniMind" 项目提供了一个仅有 26M 参数的小型 GPT 模型,这使得它在资源有限的设备上也能运行。

- 低硬件要求

该项目支持在最低只需 2G 显存的显卡上进行模型的推理训练,这大大降低了训练大型语言模型的硬件门槛。

- 快速训练

项目声称可以在 3 小时内从零开始训练模型,这对于需要快速迭代和测试的研究人员和开发者来说是一个巨大的优势。

- 开源和社区支持

作为一个开源项目,"MiniMind" 鼓励社区成员参与贡献,共同推动项目的发展和完善。

应用场景

- 学术研究

研究人员可以使用 "MiniMind" 来快速训练和测试新的模型架构,而无需担心高昂的计算成本。

- 教育和学习

教育机构和学生可以利用这个项目来学习和实践自然语言处理技术,而不受硬件资源的限制。

- 小型企业和初创公司

对于资源有限的小型企业和初创公司,"MiniMind" 提供了一个低成本的解决方案来开发和部署自然语言处理应用。

- 个人开发者

个人开发者可以利用 "MiniMind" 来构建自己的语言模型,进行个性化的自然语言处理任务。

结语

"MiniMind" 作为一个轻量级的大模型训练和推理工具,为自然语言处理领域带来了新的可能。它的低硬件要求和快速训练能力,使得更多的人能够参与到大模型的研究和应用中来。

MiniMind 地址

此处含有隐藏内容,请提交评论并审核通过刷新后即可查看!

正文完