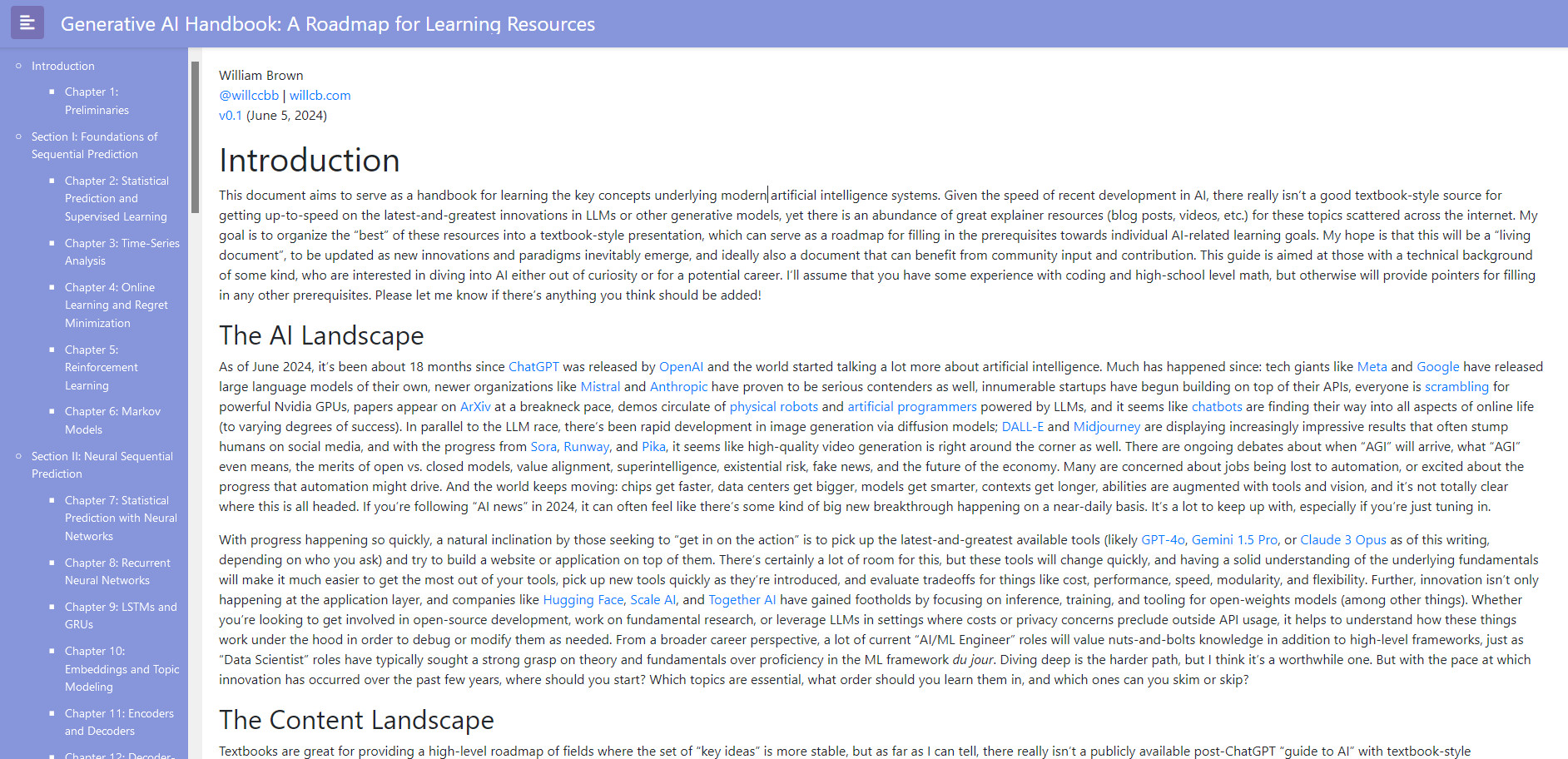

"GenAI Handbook" ,一个旨在作为学习现代人工智能系统背后关键概念的手册。该手册由 William Brown 编写和维护。

手册的主要内容包括:

- 引言:介绍了创建这个手册的目的,即为对 AI 感兴趣的人提供一个有组织的学习资源路线图。

- AI 领域概况:讨论了自 2024 年 6 月以来 AI 领域的快速发展,包括大型语言模型(LLMs)和其他生成模型的最新进展。

- 内容景观:评估了当前可供学习 AI 的资源,包括教科书、在线课程、博客文章、视频等,并指出了它们的优势和局限性。

- 资源:列出了将用于本手册的资源,包括博客、YouTube 频道、教科书和在线课程等。

- 预备知识:涵盖了学习现代深度学习所需的数学和编程基础,特别是微积分和线性代数,以及 Python 编程语言。

- 统计预测与监督学习:介绍了概率论和机器学习的基础概念,如随机变量、监督与非监督学习、回归与分类、线性模型和正则化等。

- 时间序列分析:讨论了时间序列分析的基本概念及其在理解复杂生成 AI 方法中的作用。

- 在线学习与遗憾最小化:介绍了在线学习的基础和遗憾最小化的概念。

- 强化学习:探讨了强化学习的基础及其在微调方法中的应用。

- 马尔可夫模型:介绍了马尔可夫模型和它们在机器学习中的应用。

- 神经网络的统计预测:深入探讨了神经网络的基础知识,包括前馈网络和反向传播。

- 循环神经网络:介绍了 RNNs 及其在序列预测问题中的应用。

- LSTM 和 GRU:讨论了 LSTM 和 GRU 网络,这些网络在处理具有挑战性的数据领域(如语言)时提高了性能。

- 嵌入和主题建模:介绍了嵌入的概念以及它们在 NLP 中的应用。

- 编码器和解码器:探讨了序列到序列的编码器-解码器架构及其在机器翻译中的应用。

- 仅限解码器的 Transformer:深入研究了 Transformer 模型的内部构件,如多头注意力、跳跃连接和位置编码。

- 分词:讨论了分词技术及其在提高 Transformer 模型效率中的作用。

- 位置编码:介绍了 Transformer 中的位置编码技术,如正弦位置编码和旋转位置编码。

- 预训练配方:探讨了预训练大型语言模型时需要考虑的各种选择和策略。

- 分布式训练和 FSDP:讨论了在多台机器上训练大型模型时使用的分布式训练协议。

- 扩展定律:介绍了扩展定律及其在训练语言模型中的应用。

- Mixture-of-Experts (MoE):探讨了 MoE 架构及其在提高模型效率中的作用。

- 指令微调:介绍了如何使用指令微调技术来调整 LLMs 的风格或格式。

- 低秩适配器 (LoRA):讨论了使用 LoRA 进行参数高效微调的方法。

- 奖励模型和 RLHF:介绍了如何使用人类反馈来训练奖励模型,并将其用于通过 RL 策略梯度技术持续训练 LLMs。

- 直接偏好优化方法:探讨了直接偏好优化(DPO)及其在对齐 LLMs 方面的应用。

- 上下文扩展:讨论了如何通过额外的训练或调整位置编码参数来增加模型的有效上下文长度。

- 蒸馏和合并:介绍了通过蒸馏和合并来整合跨 LLMs 的知识的方法。

这个手册还包括了关于如何提高预训练 Transformer 语言模型的推理速度和效率的技术,以及如何测量和理解它们的性能。此外,还涵盖了多模态模型、生成模型、条件 GANs、扩散模型等主题。

© 版权声明

版权声明:本文内容采用 CC BY-NC-SA 4.0 协议许可,转载请注明

根据《计算机软件保护条例》第十七条规定“为了学习和研究软件内含的设计思想和原理,通过安装、显示、传输或者存储软件等方式使用软件的,可以不经软件著作权人许可,不向其支付报酬。”本站所有内容资源均来源于网络,仅供用户交流学习与研究使用,版权归属原版权方所有,版权争议与本站无关,用户本人下载后不能用作商业或非法用途,需在24小时内从您的设备中彻底删除下载内容,否则一切后果请您自行承担,如果您喜欢该程序,请购买注册正版以得到更好的服务。

THE END

暂无评论内容